之前写了两篇关于Deepseek 本地化部署的文章 win版本和linx版本。可能很多小伙伴不具备一定的部署能力。

下面出一版相对更加简单的部署方式:

接住第三方工具去部署:

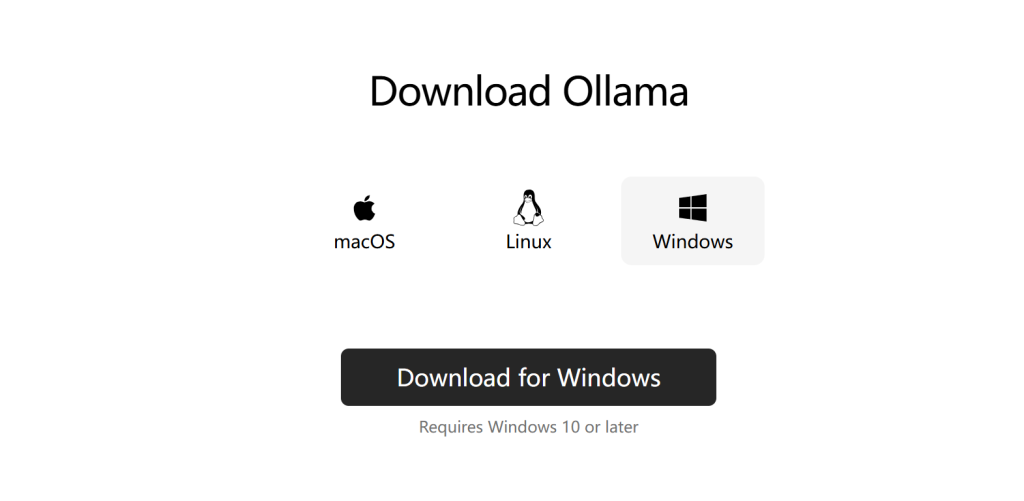

ollama https://ollama.com/

根据自己的电脑系统版本去下载对应的工具端

下载直接安装 一直下一步。

模型下载:

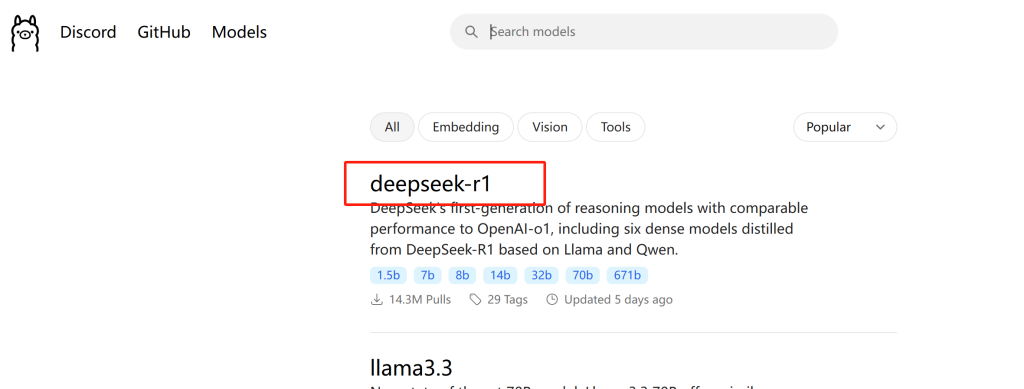

有关模型的下载 我这里废话一下:

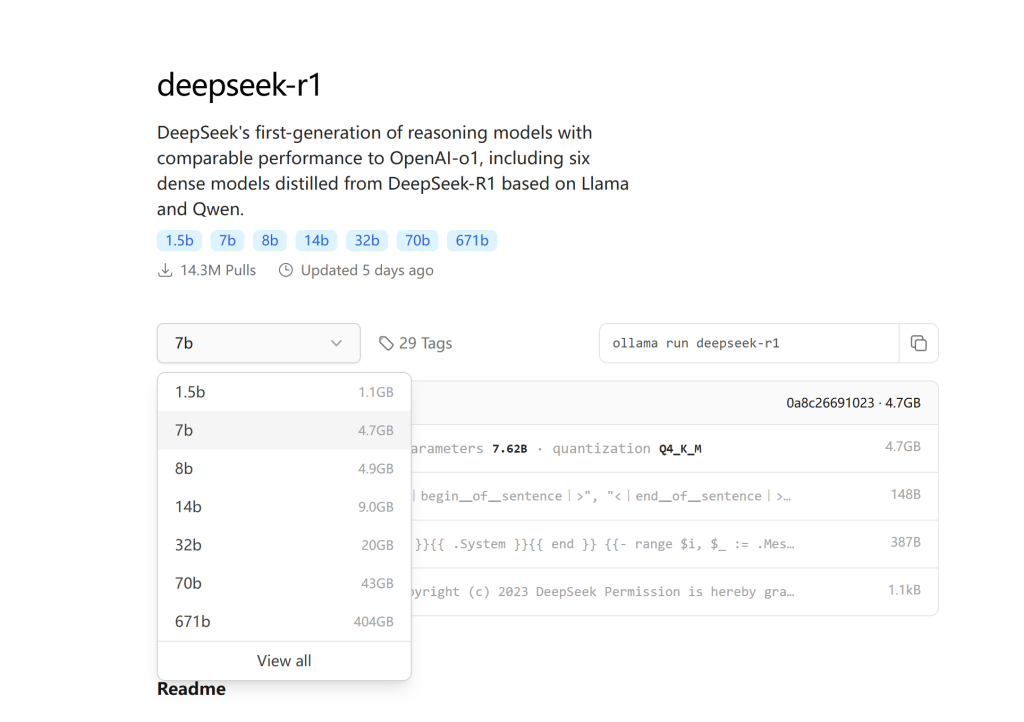

版本:1.5b,适用于一般文字编辑使用(需要1.1GB空余空间)ollama run deepseek-r1:1.5b版本:7b,DeepSeek的第一代推理模型,性能与OpenAl-01相当,包括从基于Llama和Qwen的DeepSeek-R1中提取的六个密集模型(需要4.7GB空余空间)ollama run deepseek-r1:7b版本:8b,(需要4.9GB空余空间)ollama run deepseek-r1:8b版本:14b,(需要9GB空余空间)ollama run deepseek-r1:14b版本:32b,(需要20GB空余空间)ollama run deepseek-r1:32b版本:70b,(需要43GB空余空间)ollama run deepseek-r1:70b版本:671b,(需要404GB空余空间)ollama run deepseek-r1:671b

根据自己的电脑配置情况 下载对应的模型

一下是如何下载模型:

先贴出来 等下要复制的 命令

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

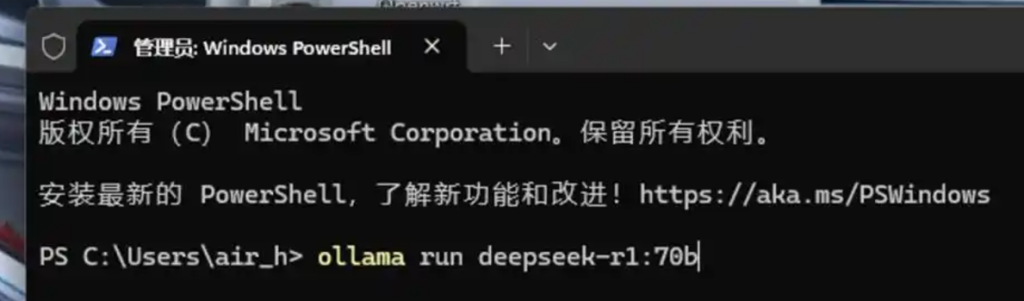

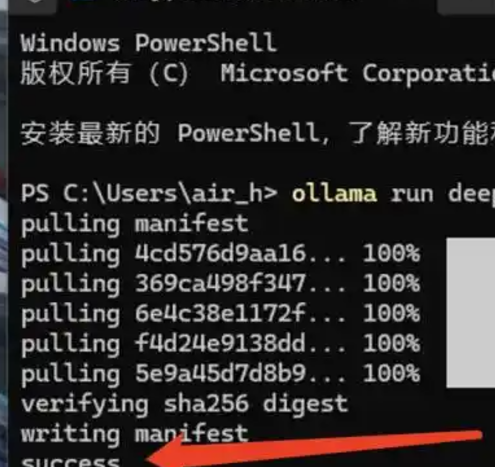

ollama run deepseek-r1:70b(模型会直接安装在C盘,请注意C盘的可用空间!)这里尝试安装一下 7b 的版本,复制刚刚的ollama run deepseek-r1:7b 命令行,粘贴到【PowerShell(管理员】运行框,然后回车

下载可能会根据网络等情况 等待的时间可能会不一样 下载成功后会出现success 等字样

同时会进入命令对话模式

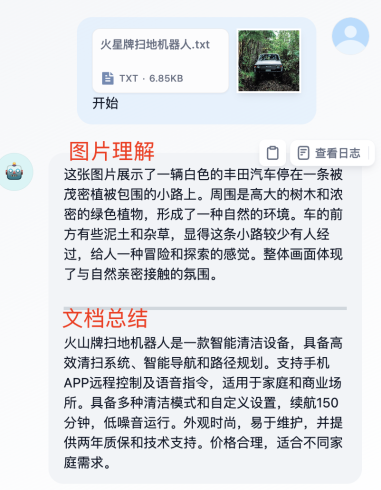

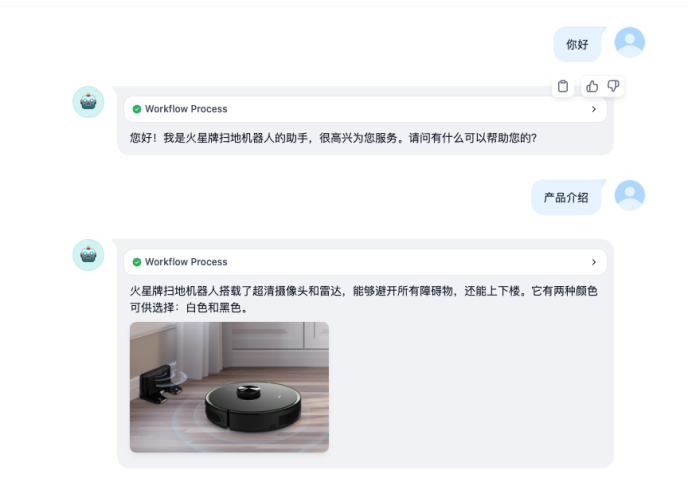

图形化工具

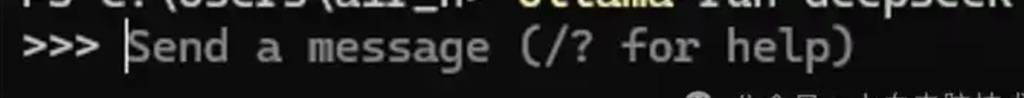

刚才我们已经部署好了 deepseek ,但是使用起来不是很方便,下面我们借助第三方工具 实现图形化对话模式。

工具有多样性:推荐一款 Chat box

具体配置如下:

下载 安装 不多说了 一直下一步就行

直接从界面设置开始

点击设置 菜单 进入到 设置界面

如果你是直接在同一台电脑上 部署的 deepseek 模型 以及chatbox 。部署成功是可以在模型里面看到你下载并安装好的大模型。只需要点保存即可直接对话,就这么简单。

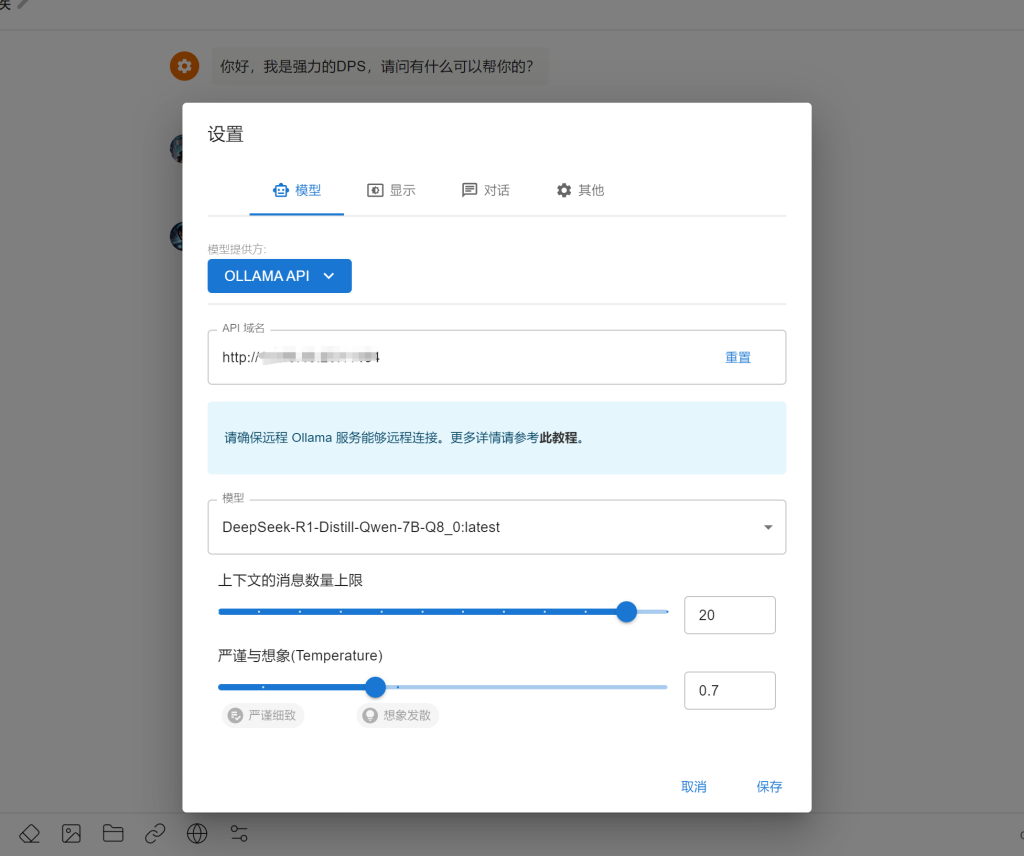

局域网访问

如果是在本地服务器部署后 想和其他小伙伴分享共同使用的话需要做一下简单的配置

1、关闭服务端防火墙,或者防火墙允许端口通过 具体端口根据每个人部署的情况不同 端口是不一样的 一般为11434

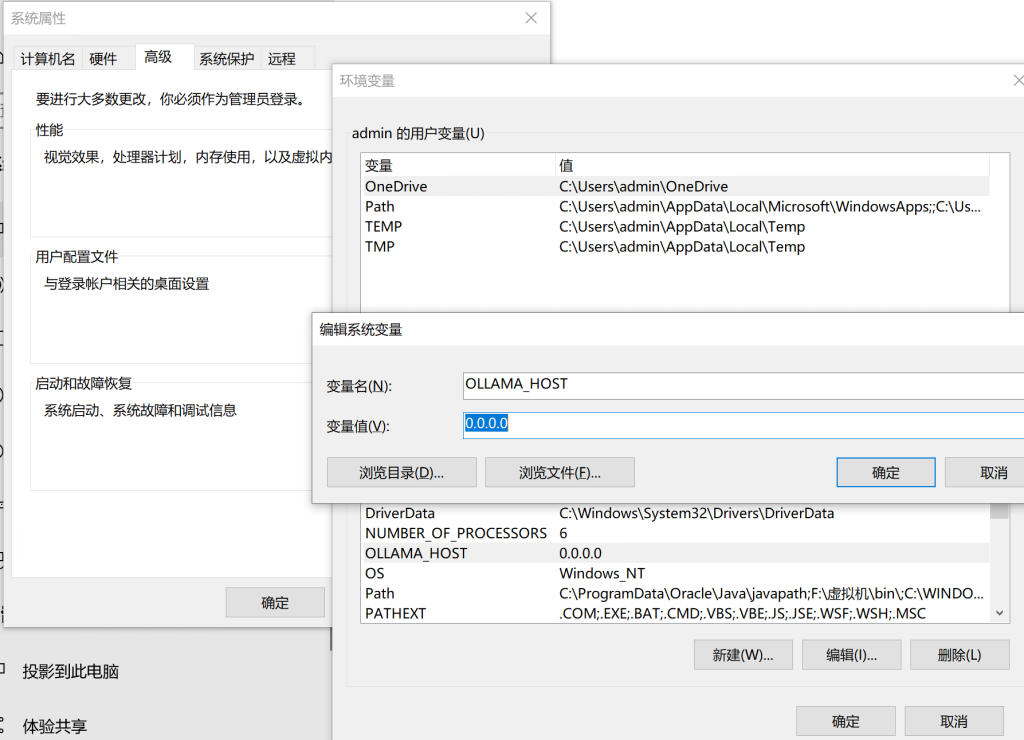

2、环境变量设置

新建

变量 OLLAMA_HOST

变量值 0.0.0.0

完成以上 只需要在 其他小伙伴的客户端吧 地址修改为服务器端IP 即可

请登录后查看评论内容